最近一段時間,國產大模型DeepSeek-R1在市場上迅速崛起,成為了眾多用戶的新寵。然而,伴隨其熱度與用戶量的急劇攀升,由此導致服務器繁忙的狀況頻繁出現。

為了擺脫服務器繁忙的困擾,本地部署DeepSeek-R1成為了一個絕佳的解決方案,這不僅減少了對網絡連接的依賴,還能增強數據安全性。接下來,就讓我們一起來看看如何操作吧。

1、下載并安裝Ollama

Ollama是一款開源的本地化大模型部署工具,用戶可以通過Ollama輕松安裝、配置和運行各種開源大模型。

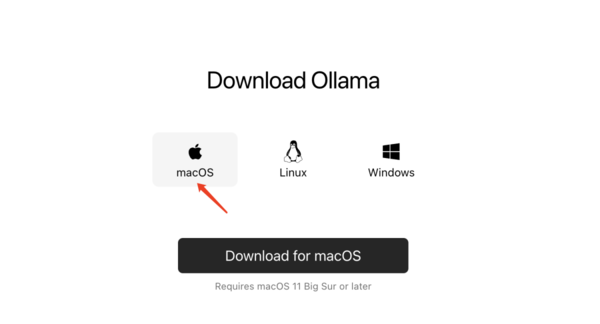

?進入Ollama官網(網址為https://ollama.com/download),該平臺支持macOS、Linux、Windows系統,根據電腦系統選擇對應的版本下載。

以小編使用的Macbook Air為例,選擇“macOS”,點擊下載。

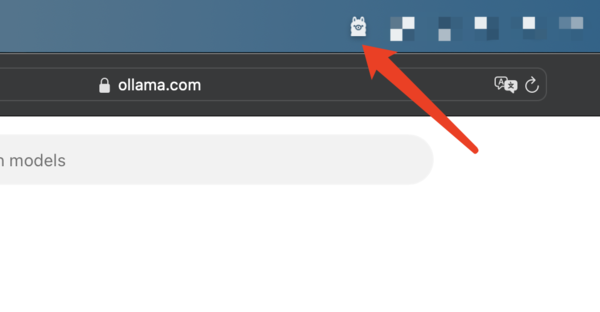

下載完成后,雙擊安裝程序并按照提示完成安裝。如果在頂部菜單欄中看到這個羊駝圖標,即表示Ollama在運行狀態。

2、安裝DeepSeek-R1

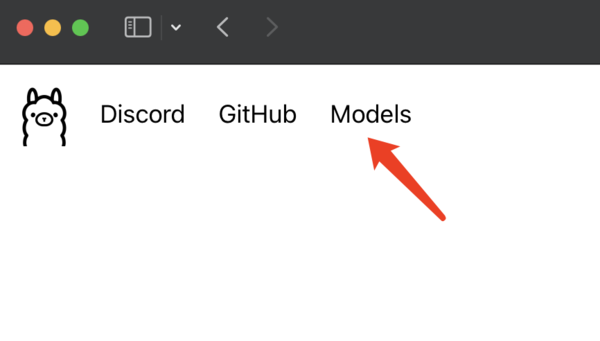

接下來,我們回到Ollama官網,在左上角找到 “Models” 點擊進入。

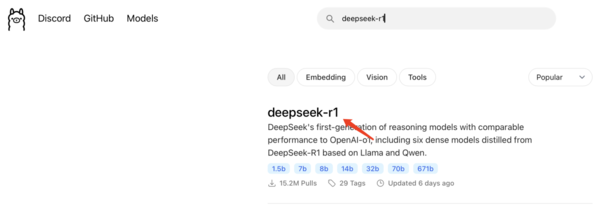

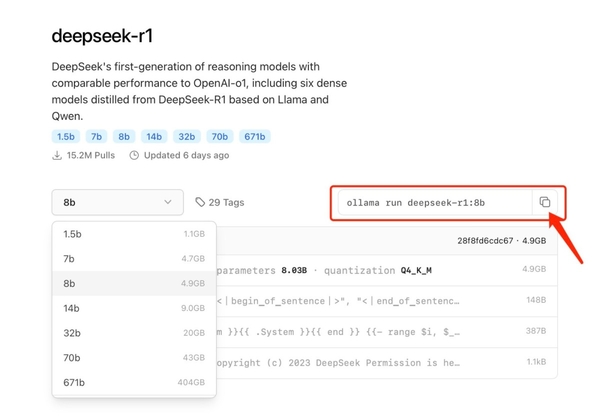

在搜索框中輸入deepseek-r1,找到“deepseek-r1”,點擊進入詳情頁。

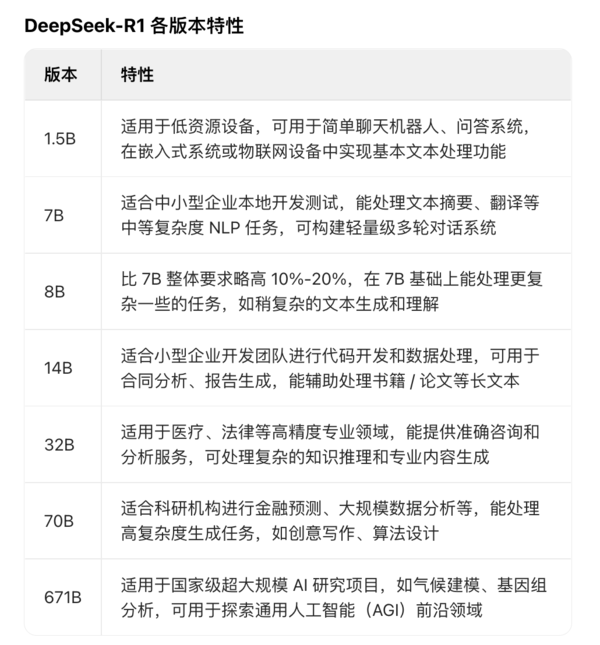

DeepSeek-R1有諸多類型,每個類型的名稱后跟隨的 1.5B、7B、14B 等,是模型的參數量。大家可根據自身電腦的硬件配置情況選擇參數。

(上圖:DeepSeek-R1各版本特性)

需要注意的是,模型的參數量與處理數據及生成內容的復雜程度呈正相關。參數量的增大,模型具備處理更為復雜數據的能力,生成的內容也相應更為豐富多樣,但對電腦的硬件配置要求也越高。

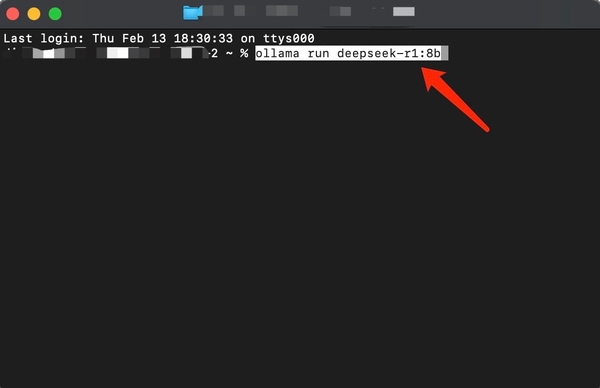

小編選擇的是8b版本,并復制“ollama run deepseek-r1:8b”命令。

調出電腦的“啟動臺”,搜索“終端”并點擊進入,將命令粘貼到“終端”窗口,按下回車鍵,等待安裝完成。

3、下載并安裝Chatbox

Chatbox是一款智能對話工具,結合了人工智能技術和便捷的操作界面,支持Windows、MacOS、Linux、Android、iOS及網頁端,可幫助用戶快速完成任務。

進入Chatbox官網(網址為https://chatboxai.app/zh),找到適合自己電腦系統的版本,下載并完成安裝。

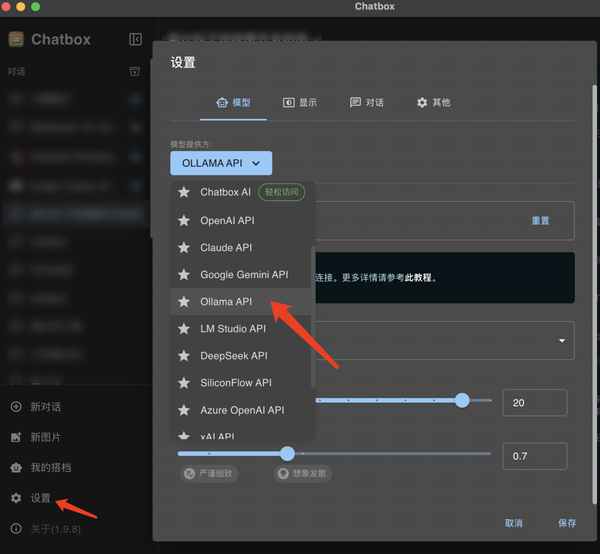

下載完成后,打開Chatbox,點擊“設置”,在“模型提供方”中選擇“OLLAMA API”。

在“模型”列表中,選擇已經安裝好的“deepseek-r1:8b”,點擊“保存”。

完成以上三個步驟,就可以在Chatbox中,與DeepSeek-R1展開對話了。

寫在最后:

在人工智能快速蓬勃發展的當下,學會使用大模型,無疑能夠讓我們在信息處理和知識獲取等方面占據優勢。相信大家在使用過程中可以充分發掘DeepSeek-R1的潛力,創造出更多成果。

供稿單位:重慶天極網絡有限公司

審核專家:李志高 高級工程師/重慶天極網絡有限公司總裁

聲明:除原創內容及特別說明之外,部分圖片來源網絡,非商業用途,僅作為科普傳播素材,版權歸原作者所有,若有侵權,請聯系刪除。

來源: 重慶市科學技術協會

內容資源由項目單位提供

科普中國公眾號

科普中國公眾號

科普中國微博

科普中國微博

幫助

幫助

重慶市科學技術協會

重慶市科學技術協會