科技部監督司發布《負責任研究行為規范指引(2023)》,針對社會關注的人工智能、重大成果發布等熱點問題,旗幟鮮明地劃定了紅線。

篡改實驗數據、實驗圖片造假、論文不當署名、教材編寫抄襲……1 月 16 日下午,華中農業大學的 11 名學生「一紙訴狀」,以一份 125 頁的舉報材料實名舉報該校黃姓教授存在學術不端行為。一時間,輿論迅速發酵,「賭上前程捍衛學術清白」、「人人都是學術造假受害者」等相關內容在各大平臺引發熱烈討論。

有網友由此聯想到了此前的阿爾茲海默癥開山論文造假事件,這篇被引用 2300 余次的 Nature 論文誤導了全球阿爾茨海默病研究長達 16 年。

心無旁騖求是真,藝不精深未可言。過去的百余年間,學術清正之風、造福人類的崇高信仰,是指引莘莘學子在科研道路上步履不停的明燈,但如今卻摻雜了越來越多的名利誘惑,致使學術造假屢禁不止。尤其是在 AI、大模型等技術的快速發展之下,新興技術卻成為了科研作弊的「幫兇」,不僅對堅持研學的科研人員不公,虛假研究數據還可能造成嚴重后果。

所以,在嚴查學術造假的同時,規范 AI 等技術在科研中的應用也十分重要。

劃清邊界,依規合理使用生成式人工智能

學術論文造假由來已久,除了抄襲,編造數據等常規手段,花錢請寫手、 「論文工廠」代寫、炮制論文等行為也是屢見不鮮。

如今,以 ChatGPT 為代表的生成式人工智能技術 (AIGC) 橫空出世,人們寫論文提供了新幫手。從選題篩選到文稿潤色、從統計分析到圖表制作……其功能之強大,幾乎覆蓋了學術論文寫作過程的方方面面,的確可以幫助科研人員快速完成文獻檢索、數據處理、翻譯潤色等工作。

但凡事都有雙面性,如果研究人員將 AIGC 生成的文本當作自己的創作,很大程度上會產生毫無價值的「學術泡沫」。此外,過度依賴 AIGC 產生不可靠的研究成果,將導致科學研究的可信度大打折扣。

2023 年 12 月 21 日,**科技部監督司發布《負責任研究行為規范指引(2023)》(以下簡稱《指引》),**針對社會關注的人工智能、重大成果發布等熱點問題,旗幟鮮明地劃定了紅線。

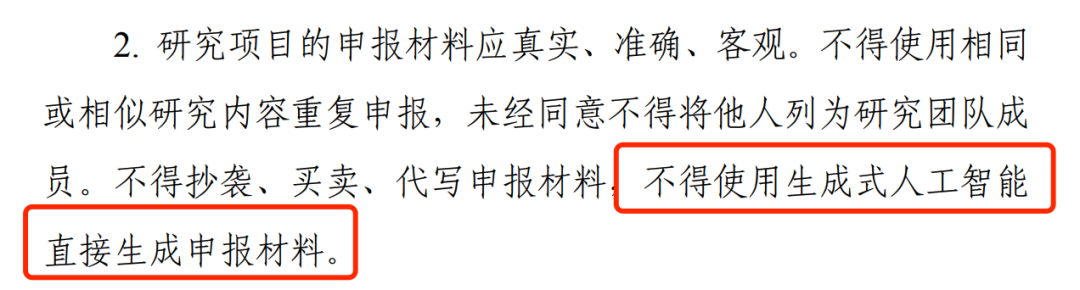

《指引》在研究選題與實施部分指出:科研人員研究項目的申報材料應真實、準確、客觀。不得使用相同或相似研究內容重復申報,未經同意不得將他人列為研究團隊成員。不得抄襲、買賣、代寫申報材料,不得使用生成式人工智能直接生成申報材料。

應遵循相關法律法規及學術規范,依規合理使用生成式人工智能處理文字、數據或學術圖像,防范偽造、篡改數據等風險。

在文獻引用上,《指引》也明確規定了:使用生成式人工智能生成的內容,特別是涉及事實和觀點等關鍵內容的,應明確標注并說明其生成過程,確保真實準確和尊重他人知識產權。對其他作者已標注為人工智能生成內容的,一般不應作為原始文獻引用,確需引用的應加以說明。不得直接使用未經核實的由生成式人工智能生成的參考文獻。

《指引》從研究實施、數據管理、成果署名與發表、文獻引用等方面明確了合理使用生成式人工智能的邊界,對于保護科學研究的可信度和倫理原則具有重要意義,有助于防止不負責任地使用生成式 AI 及相關技術。

國內外知名期刊對 AI 生成論文進行規范

學術論文造假是一個全球性的問題,生成式 AI 的出現在一定程度上降低了造假門檻,ChatGPT 等聊天機器人「一本正經說瞎話且能自圓其說」的能力更是為這些人提供了便利。但隨著 AIGC 的使用邊界不斷清晰,除了明確法規規范外,國內外也有越來越多的學術機構已經達成共識,開始正視并規范 AI 的使用。

國內多家期刊發表聲明,對投稿人在論文寫作過程中的各種 AI 使用途徑加以限制。如《暨南學報》《文獻與數據學報》《中國科技期刊研究》《智庫理論與實踐》《圖書情報工作》等期刊均發表聲明稱,如果論文主要內容是利用 AI 工具生成,一旦發現,以學術不端行為處理。

國外學術期刊也紛紛對 AI 在論文寫作中的應用進行規范。據不完全統計,Nature(自然)、Cell(細胞)、The Lancet(柳葉刀)、JAMA(美國醫學會雜志)等頂級期刊均發表聲明稱,人工智能不具有作者資格,使用人工智能的研究人員應在稿件中進行說明。

用 AI 打敗 AI ,揪出論文「槍手」

推動 AI 向善發展,需要借助行之有效的技術手段。值得注意的是,在當前的技術水平下,AI 生成的論文在形式上與原創論文相似,傳統的文本相似度比對工具可能無法準確檢測出它們。因此,國內外都在探索研發專門針對 AIGC 的檢測工具。

「AI 生成內容識別器的核心思想是首先構建一個訓練數據集,包含真實的內容和 AI 生成的內容,然后訓練一個分類器來區別這兩類內容。」MILA 研究院知名華人學者唐建在接受媒體采訪時解釋道。

具體而言,人工智能語言模型通過一次預測和生成一個單詞來工作。生成一個詞后,水印算法將語言模型的詞匯隨機分為「綠名單」和「紅名單」,然后提示模型選擇「綠名單」上的詞。一篇文章中列入「綠名單」的詞越多,該文本就越有可能是由機器生成的,人類寫的文本往往包含更隨機的單詞組合。

簡單來說,AIGC 檢測技術是在「用 AI 打敗 AI 」,依托海量的文本和數據樣本,識別出人類和 AIGC 工具在平均句子長度、詞匯多樣性和文本長度等方面的不同點,從而揪出 AI 論文「槍手」。

但這背后存在一些技術難點,比如語言模型經過人類創作文本訓練,參數量越大,越接近人類創作,越難以區分;另外,檢測還受限于文本長度,文本長度足夠長,檢測的準確率才有保障。

科研中合理使用 AI,不可因噎廢食

AI for Science 的成功應用,在一定程度上將科研人員從文本、數據的處理工作中「解救」出來,使其能夠更加專注于研究本身,可以在一定程度上提升效率,加快科學研究的進度。此外,在完成一些深度、復雜科研內容的探索上,人工智能也毫不遜色。

比如近年來醫學研究領域備受重視的預測模型,讓有些科研新人抓耳撓腮。而 AI 可以逐步建立思路和方法,幫助科研人員快速構建一個合格的模型。

再比如,在實驗設計與優化方面,只需簡單提供實驗目的、方法和材料等信息,AI 便可生成詳細的實驗方案,幫助科研人員對已有的方案進行評估優化,減少實驗消耗。

總之,對生成式人工智能不可「談虎色變」,而要加以規范和引導,讓它沿著正確的軌道為科學研究服務。對于科研人員而言,要善用 AI 技術,借助它的優勢高效、準確地完成科研和論文的撰寫,但所有的觀點和數據,必須要經過作者的審查,避免生成式 AI 的一些虛假和杜撰的結論,以維護科學的尊嚴。

其實這也恰恰是 AI for Science 的初衷,利用 AI 實現對傳統科研范式的重塑與創新。如今 AI for Science 已經在生物醫藥、材料化學、數學、物理等眾多領域完成了升級,并且創造了一批具有實際應用價值的重要成果。但是,很多科研人員仍持觀望態度,一方面是所在領域可能缺乏低門檻的 AI 工具,另一方面也可能是尚未找到 AI 與其研究領域的結合點。

AI for Science 的探索之旅才剛剛啟程,唯有科研與 AI 攜手并進,才能創造出更普適的工具與方法。

來源: HyperAI超神經

科普中國公眾號

科普中國公眾號

科普中國微博

科普中國微博

幫助

幫助

HyperAI超神經

HyperAI超神經